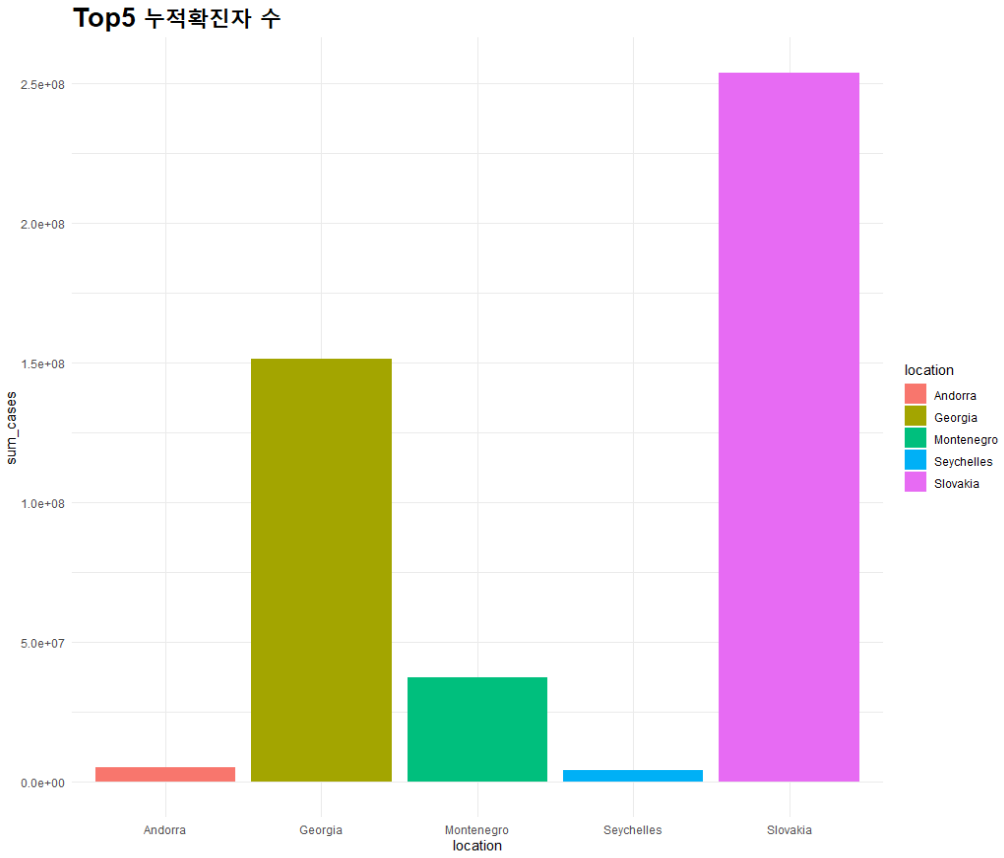

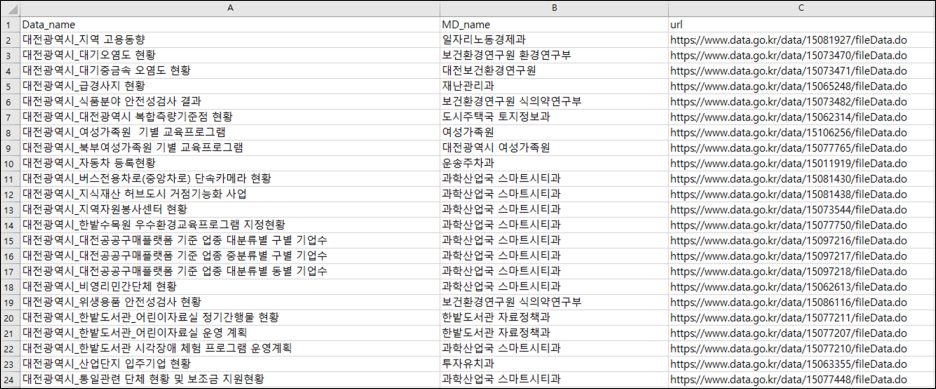

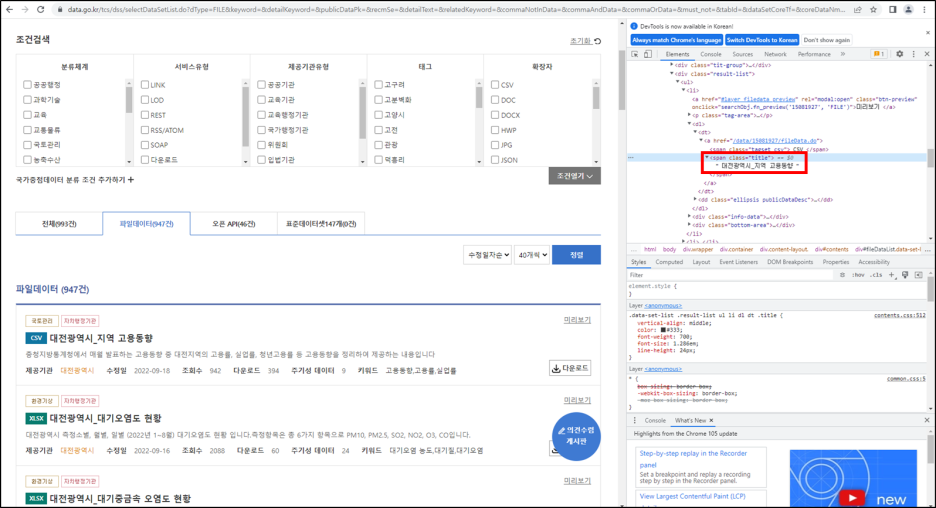

※ 개인적으로 ADP 실기 문제들을 풀이하려고 합니다. 사용 언어는 'R 프로그래밍'입니다. ※ 코드 및 관련 의견 주심 감사하겠습니다. 문제 복기 참고 사이트 https://www.datamanim.com/dataset/ADPpb/00/20.html ADP 20회 실기 문제 — DataManim 2-1번 데이터 전처리 각 가구의 15분간격의 전력량의 합을 구하고 해당데이터를 바탕으로 총 5개의 군집으로 군집화를 진행한 후 아래의 그림과 같은 형태로 출력하라. 군집화를 위한 데이터 구 www.datamanim.com 1-1. 데이터 확인 및 전처리 데이터 EDA 수행 (결측치 확인 및 처리 방안 논의) 날씨의 온도를 예측하는 것, 종속변수 : actual(최고온도) df